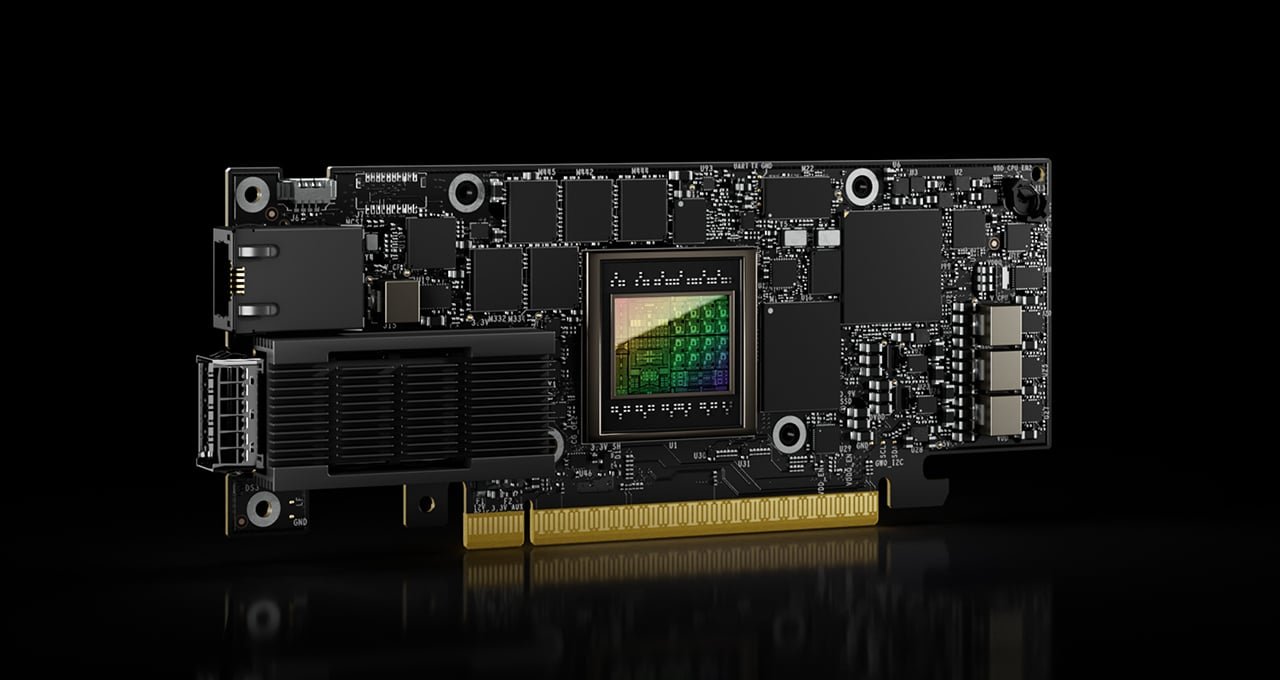

NVIDIA hat das ConnectX-8 SuperNIC vorgestellt – eine neue Netzwerkkarte, die weit über klassische NICs hinausgeht.

Sie ist ein dedizierter ASIC, der GPUs direkt mit riesigen KI-Clustern verbindet und so Training wie auch Inferenz deutlich effizienter macht.

Der Unterschied ist entscheidend: Training läuft über lange, synchronisierte Prozesse, bei denen jede zusätzliche Latenz die Effizienz killt. Inferenz dagegen ist extrem latenzkritisch und ständig im Austausch mit der Außenwelt. Das ConnectX-8 SuperNIC liefert dafür eine flexible End-to-End-Netzwerkarchitektur, die beide Szenarien abdeckt.

Das Board unterstützt Spectrum-X Ethernet und Quantum-X InfiniBand, liefert bis zu 800 Gbit/s und setzt auf PCIe Gen6 mit 48 Lanes über einen integrierten Switch. Mit an Bord: RDMA auf Millionen GPUs, Load Balancing, Congestion Control, Enterprise-Security und ein Data-Path-Accelerator auf RISC-V-Basis (16T), der speziell auf KI-Workloads zugeschnitten ist.

Zum ersten Mal wird das SuperNIC in den NVIDIA Blackwell GB300 NVL72-Systemen eingesetzt, wo Grace-CPUs, Blackwell-Ultra-GPUs und NVLINK C2C eng verzahnt sind. Jede NVL72-Platine nutzt zwei CX8-Switches, die Bandbreite und Quality of Service zwischen CPU, GPU und SSD optimieren.

Laut NVIDIA bringt die Kombi aus ConnectX-8 und Spectrum-X bis zu 1,6x mehr effektive Bandbreite, 2,2x höhere all-reduce Performance und praktisch null Tail-Latenz. Telemetriedaten werden dabei tausendmal schneller erfasst als mit Standard-RDMA-NICs.

Während AMD lediglich 800G-Ethernet-IP-Cores anbietet, die Kunden in eigene Lösungen einbauen müssen, liefert NVIDIA ein sofort einsatzbereites Hardwareprodukt. Die Strategie ist klar: Komplettpakete für KI-Rechenzentren, die ohne langes Tuning direkt skalieren.

2 kommentare

digga, du checkst es nicht… frag halt chatgpt 🤣

Müll. Ende der Diskussion