NVIDIA dominiert weiter die KI-Welt – doch spezialisierte Chips holen rasant auf

Seit Jahren gilt NVIDIA als das Rückgrat der modernen Künstlichen Intelligenz. Die GPUs des Unternehmens treiben Sprachmodelle wie ChatGPT an, trainieren neuronale Netze und stehen im Zentrum zahlloser Rechenzentren. Doch 2025 zeichnet sich ein Wandel ab: Energieverbrauch, Kostenexplosion und Chip-Knappheit machen maßgeschneiderte KI-Prozessoren – sogenannte ASICs (Application-Specific Integrated Circuits) – immer attraktiver.

Um die neuen Kräfteverhältnisse zu verstehen, sprachen wir mit Rahul Sen Sharma, Präsident und Co-CEO von Indxx, einem internationalen Indexanbieter, der technologische Trends analysiert. Sharma beschreibt, warum NVIDIA zwar noch immer der König der KI-Hardware ist, aber zunehmend Konkurrenz von spezialisierten Chipdesigns bekommt, die Kosten senken und Effizienz steigern.

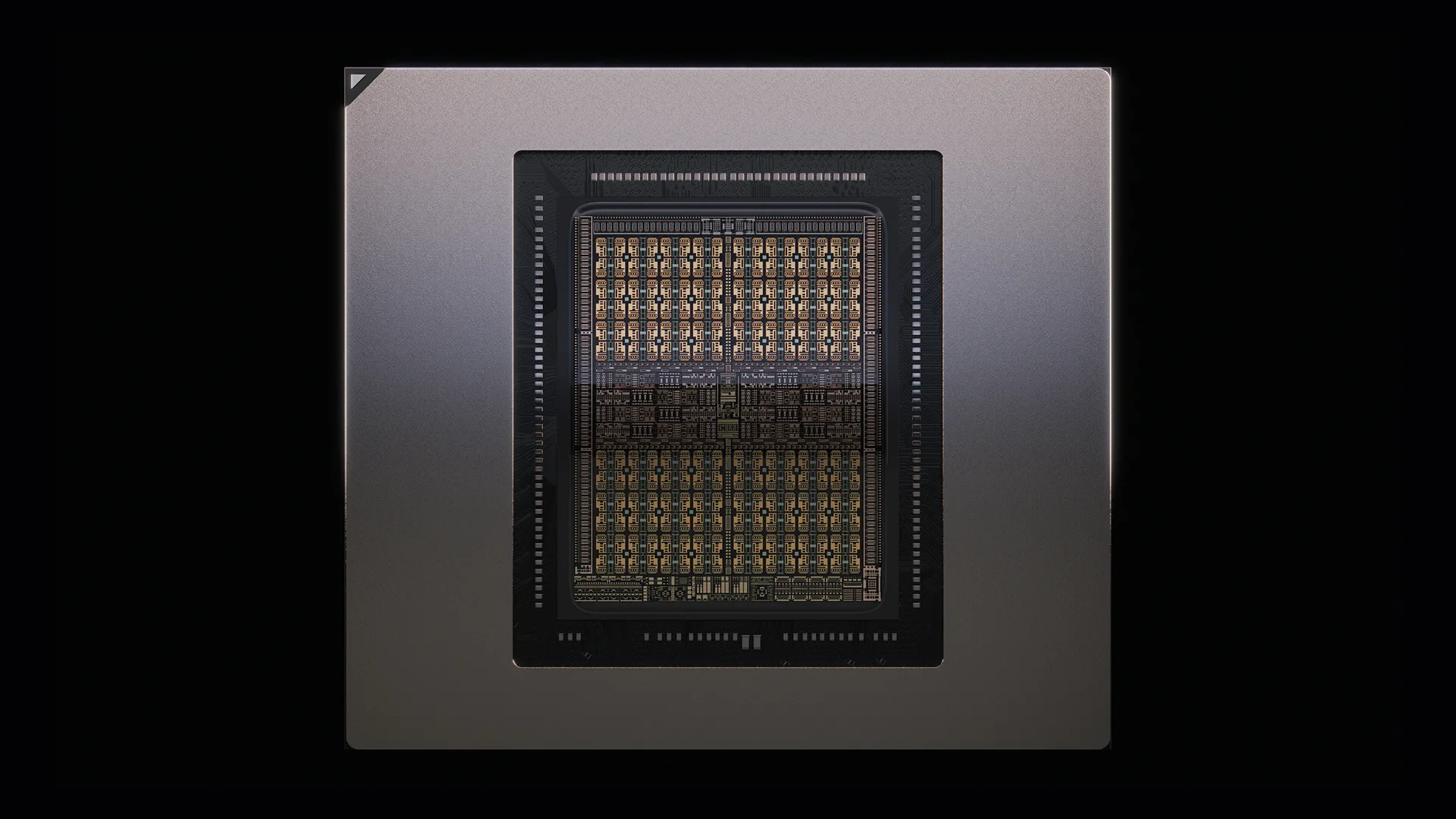

CUDA und Blackwell – das Erfolgsduo

NVIDIA beherrscht rund 86 Prozent des globalen Markts für KI-GPUs. Diese Dominanz beruht auf zwei Säulen: extrem leistungsfähiger Hardware und der proprietären Softwareplattform CUDA. CUDA hat sich als Standard für KI-Entwicklung etabliert und bindet Entwickler fest an das Ökosystem von NVIDIA. Dadurch bleibt das Unternehmen selbst in Ländern wie China stark vertreten, wo Exportbeschränkungen den Zugang zu modernsten Chips erschweren.

Die aktuelle GPU-Generation Blackwell ist das Herz vieler KI-Systeme – vom Training großer Sprachmodelle bis zur Bilderkennung. „NVIDIA verkauft nicht nur Chips, sondern ein komplettes Ökosystem“, sagt Sharma. „Die Kombination aus Hardware und Software hat eine Markteintrittsbarriere geschaffen, die kaum zu überwinden ist.“

Doch der Vorsprung schrumpft

Die Entwicklung geht jedoch weiter. Immer mehr Tech-Giganten setzen auf eigene ASICs – maßgeschneiderte Chips, die exakt für bestimmte KI-Aufgaben entworfen wurden. Anstatt universell zu sein, wie GPUs, sind sie spezialisiert und dadurch effizienter und sparsamer im Betrieb. OpenAI etwa arbeitet gemeinsam mit Broadcom an einem Inferenz-Chip, gefertigt im 3-Nanometer-Verfahren von TSMC. Diese Chips sind ausschließlich für den Eigenbedarf gedacht und sollen die Abhängigkeit von NVIDIA verringern.

Auch Google mit seinen TPUs, Amazon mit Trainium und Inferentia, Microsoft mit Athena und Meta mit MTIA verfolgen denselben Ansatz: Kostenkontrolle, Energieeffizienz und mehr Unabhängigkeit. Damit entsteht ein hybrides Modell: NVIDIA bleibt die erste Wahl für extremes Training, während maßgeschneiderte Chips zunehmend die alltägliche Inferenz übernehmen.

Broadcom – vom Netzwerk- zum KI-Giganten

Ein Name taucht in dieser neuen Ära besonders häufig auf: Broadcom. Das Unternehmen, einst hauptsächlich für Netzwerk- und Speicherchips bekannt, hat sich zu einem ernstzunehmenden Wettbewerber im KI-Hardwaremarkt entwickelt. Im zweiten Quartal 2025 erzielte Broadcom mit KI-Produkten 4,4 Milliarden US-Dollar Umsatz – ein Wachstum von 46 Prozent im Vergleich zum Vorjahr. Der Erfolg beruht auf der engen Zusammenarbeit mit Hyperscalern und dem Fokus auf speziell angepasste Chips.

„Broadcom positioniert sich clever“, meint Sharma. „Sie zielen nicht darauf ab, NVIDIA in allen Bereichen zu übertrumpfen, sondern besetzen gezielt Segmente, in denen Effizienz wichtiger ist als pure Rechenleistung.“ Durch den Kauf von VMware und Kooperationen mit Cloud-Anbietern hat Broadcom eine strategische Plattform geschaffen, die ihnen einen festen Platz im KI-Ökosystem sichert.

Der Trend: Kosten statt nur Leistung

Der klassische Wettlauf um maximale Performance stößt an physikalische und wirtschaftliche Grenzen. Der Energieverbrauch von Rechenzentren explodiert, während Renditen sinken. „Hyperscaler setzen heute auf Kosten-Performance, nicht mehr nur auf rohe Leistung“, erklärt Sharma.

Amazon ist dafür ein gutes Beispiel. Mit den hauseigenen Trainium-Chips opfert AWS zwar Spitzenleistung, gewinnt aber durch niedrigere Betriebskosten und bessere Integration in die eigene Cloud-Architektur. Google nutzt seine TPUs ähnlich strategisch, während Microsoft und Meta eigene Siliziumlösungen entwickeln. Das Ergebnis: NVIDIA bleibt relevant, doch ihre Alleinherrschaft schwindet.

Das nächste Kapitel der ASICs

Laut Sharma steht die Entwicklung der ASICs erst am Anfang. Die kommenden Generationen werden nicht nur leistungsfähiger, sondern auch sicherer und umweltfreundlicher sein. Er nennt fünf zentrale Trends:

- Energieeffizienz: Da sie nur für bestimmte Aufgaben gebaut sind, vermeiden ASICs unnötige Schaltkreise und sparen bis zu 30 % Energie gegenüber CPUs oder GPUs.

- Sicherheit: Zukünftige Chips werden über integrierte Verschlüsselung und Manipulationsschutz verfügen – ein Muss im Zeitalter von Cyberangriffen.

- Aufgabenspezialisierung: Chips, die nur für bestimmte KI-Prozesse wie Bildanalyse oder Sprachverarbeitung gebaut sind, arbeiten präziser und effizienter.

- KI-Integration: Engere Verzahnung mit neuronalen Prozessoren ermöglicht Echtzeitanalyse und selbstlernende Systeme.

- Speicherentkopplung: Technologien wie Compute Express Link (CXL) erlauben geteilte Speicherpools – ideal für große Sprachmodelle.

Diese Fortschritte machen ASICs zu einem zentralen Treiber der nächsten Phase der KI-Revolution: spezialisierter, sicherer und nachhaltiger.

Wer profitiert vom ASIC-Boom?

Die Welle neuer Chips bringt eine ganze Industrie in Bewegung. Neben den Hyperscalern profitieren Foundries, Designfirmen und Infrastrukturanbieter gleichermaßen.

- Hyperscaler: Amazon, Google, Microsoft und Meta gewinnen Unabhängigkeit und Kostenvorteile.

- Hersteller: TSMC und Samsung bleiben führend in der Fertigung; Broadcom, AMD und Intel erweitern ihr Angebot um semi-custom Lösungen.

- EDA-Tools: Firmen wie Synopsys, Cadence und Siemens liefern die Designsoftware für die neue Chipgeneration.

- Speicheranbieter: Micron, SK Hynix und Rambus entwickeln Lösungen für CXL-kompatible Architekturen.

- Kühlungsanbieter: Vertiv, Schneider Electric und CoolIT Systems profitieren von der Nachfrage nach effizienteren Kühllösungen.

Das gesamte Ökosystem rüstet sich für eine Zukunft, in der Energieeffizienz und Nachhaltigkeit genauso wichtig sind wie Rechenleistung.

Rubin GPUs: Power trifft Hitze

Auf der GTC 2025 stellte NVIDIA die Rubin- und Rubin-Ultra-GPUs vor – die leistungsstärksten Chips, die das Unternehmen je gebaut hat. Doch sie haben ihren Preis: enormen Energieverbrauch und extreme Hitze. „Rubin zwingt Rechenzentren, Kühlung neu zu denken“, erklärt Sharma. „Ohne Flüssigkühlung sind solche Systeme kaum noch betreibbar.“

Unternehmen wie CoolIT Systems und Asetek führen die Innovation an. CoolIT präsentierte neue Split-Flow-Kühllösungen, die bis zu 30 % effizienter sind als herkömmliche Systeme. Vertiv und Schneider Electric investieren massiv in hybride Kühlinfrastrukturen, die Luft- und Flüssigkühlung kombinieren. Kühlung, einst ein Randthema, wird zur strategischen Notwendigkeit.

Ein neuer Gleichgewichtspunkt

NVIDIA bleibt die dominierende Kraft der KI-Ära, doch das Monopol bröckelt. Der Markt bewegt sich hin zu einer Balance zwischen Vielseitigkeit und Spezialisierung, zwischen maximaler Leistung und wirtschaftlicher Vernunft. In dieser neuen Welt wird nicht mehr nur Geschwindigkeit zählen, sondern auch, wer am effizientesten denkt.

Oder, wie Sharma es ausdrückt: „NVIDIA wird nicht verschwinden – aber sie wird die Bühne teilen müssen.“

2 kommentare

asics sind spannend, aber die software-tools fehlen noch

rubin braucht wahrscheinlich ein eigenes kraftwerk lol