Foxconn, der taiwanische Auftragsfertiger hinter unzähligen Smartphones, Konsolen und Servern, rückt leise in eine neue Schlüsselrolle der KI-Industrie.

Jüngste Berichte aus Taiwan zufolge hat sich das Unternehmen große Bestellungen für komplette Racks rund um Googles Ironwood-TPUs gesichert – nicht auf Basis klassischer NVIDIA-GPU-Server. Das ist kein dramatischer Bruch über Nacht, aber ein deutliches Signal: Die Lieferkette für KI-Rechenzentren beginnt sich von einem reinen NVIDIA-Universum hin zu einem breiteren Ökosystem aus Spezialchips zu verschieben.

Über Jahre galten NVIDIAs Rechenzentrums-GPUs wie A100 oder H100 als alternativlos, wenn es um das Training großer Sprach- und Vision-Modelle ging. Wer ernsthaft mitspielen wollte, musste sich in eine oft frustrierende Kombination aus langen Wartelisten, hohen Preisen und knapper Verfügbarkeit einreihen. Systempartner nahmen, was sie bekommen konnten – und witzelten im Hintergrund, sie würden im Zweifel mit jedem zusammenarbeiten, „solange es nicht noch mehr schwarze Bildschirme und Treiberstress gibt“. In genau dieses Klima stoßen Googles TPUs hinein, die lange als interne Speziallösung galten und nun in Form kompletter Rack-Plattformen nach außen getragen werden.

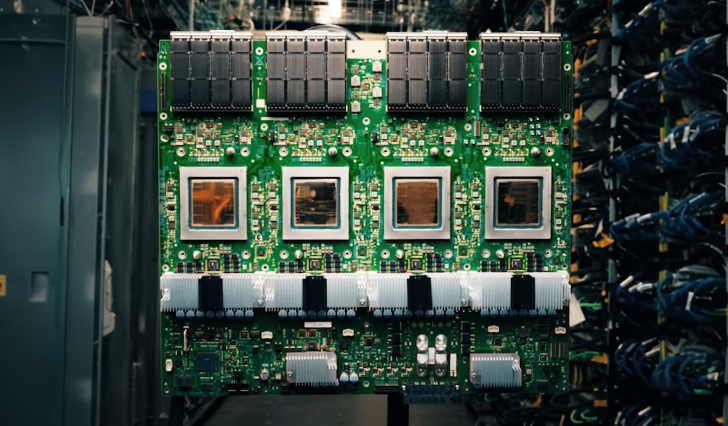

Laut der Economic Daily News erhält Foxconn Aufträge für sogenannte Compute-Trays, die direkt mit dedizierten TPU-Racks von Google gekoppelt werden. Pro ausgeliefertem TPU-Rack soll Foxconn ein Rack mit Rechenknoten fertigen – ein 1:1-Verhältnis, das zeigt, wie klar Google seine Lieferkette strukturiert. Gleichzeitig soll Foxconn auch an Googles Robotik-Ableger Intrinsic mitarbeiten, wo KI-Server und physische Automatisierung zusammenfließen. Für Foxconn ist das weniger ein Schritt ins Unbekannte, sondern die logische Erweiterung einer Rolle, die man seit Jahren für mehrere Hyperscaler spielt: maßgeschneiderte Server in industriellem Maßstab.

Technisch steckt hinter Ironwood alles andere als ein Inkremental-Update. Die siebte TPU-Generation wird in sogenannten Superpods ausgerollt: vorvalidierte Cluster, die bis zu 9 216 Chips in einem Verbund zusammenfassen. In FP8-Workloads kommt ein voll ausgebauter Superpod auf rund 42,5 ExaFLOPS an Rechenleistung. Das Ganze wird über Googles Inter-Chip-Interconnect verspannt und in einer 3D-Torus-Topologie angeordnet, sodass jeder Chip mit seinen Nachbarn extrem kurze Wege hat. Für Entwickler fühlt sich ein solcher Pod daher eher wie ein gigantischer, monolithischer Beschleuniger an als wie ein lose verschalteter Haufen Einzelkarten.

Spannend daran ist weniger die rohe Kraft als die Ausrichtung auf den aktuellen Engpass der Branche. Die ganz großen Trainingsläufe für Foundation-Modelle sind spektakulär, aber wirtschaftlich verschiebt sich der Schwerpunkt Richtung Inferenz: Chatbots, Suchabfragen, Empfehlungssysteme, Assistenten in Office-Software – all das läuft milliardenfach am Tag. Dort zählen Energieeffizienz, Latenz und Total Cost of Ownership mehr als der nächste Rekord in einem Benchmark. Spezialisierte ASICs wie TPUs oder künftige NPUs können auf klassische Grafiklogik verzichten und sämtliche Transistoren in Matrix-Einheiten, Speicherbandbreite und Interconnect stecken.

Google verfolgt seit Jahren genau diese Strategie: eigene Chips, eigene Boards, eigene Racks, eigene Compiler und ein eng verzahnter Cloud-Stack obendrauf. NVIDIA hat zwar mit A100, H100 & Co. ebenfalls vieles von der Gaming-DNA aus den Rechenzentrumsprodukten herausoperiert, muss aber weiterhin ein sehr heterogenes Kundenspektrum bedienen – von Forschungspools über Cloud-Anbieter bis hin zu On-Prem-Installationen in klassischen Unternehmen. Im Ergebnis entsteht ein interessanter Kontrast: Auf der einen Seite die eher geschlossene, stark optimierte TPU-Appliance, auf der anderen Seite die flexible, aber teurere GPU-Welt.

Dazu kommt die Preisfrage, die in vielen Unternehmen inzwischen zur Geduldsprobe geworden ist. Hinter vorgehaltener Hand klagen Einkäufer, dass bei NVIDIA-Systemen längst nicht jeder Euro in Material und Forschung fließt, sondern ein Teil schlicht dem Marktdruck und der Dominanz geschuldet ist. Hyperscaler wie Google haben dagegen ein klares Eigeninteresse daran, die Kosten pro Anfrage kontinuierlich zu drücken – je billiger die Inferenz, desto attraktiver lassen sich eigene Dienste skalieren. Die Tatsache, dass Foxconn jetzt in großem Umfang Ironwood-Racks für Google baut, legt nahe: TPUs sollen nicht länger Exoten bleiben, sondern zu einer ernsthaften, extern verfügbaren Plattform reifen.

Heißt das, „es ist vorbei“ für NVIDIA, wie mancher Meme suggeriert? Sicher nicht. Die schiere Breite des CUDA-Ökosystems, die ausgereiften Bibliotheken und das Know-how in Data-Science-Teams sind ein gewaltiger Burggraben. GPUs werden auf absehbare Zeit erste Wahl bleiben, wenn es um flexible Forschung, gemischte Workloads oder Multi-Cloud-Szenarien geht. Aber die Zeiten, in denen die Branche faktisch nur einen einzigen Lieferanten für Hochleistungs-KI hatte, laufen ab. Große Kunden bauen sich bewusst zweite und dritte Bezugsquellen auf – ob mit Googles TPUs, eigenen ASIC-Projekten oder kommenden NPUs anderer Anbieter.

Genau hier wird Foxconns Rolle spannend. Als neutraler Fertiger kann das Unternehmen Racks für sehr unterschiedliche Chip-Ökosysteme bauen und gleichzeitig die industrielle Skalierung sicherstellen. Wenn die Zukunft von KI-Infrastruktur aus einem bunten Mix aus GPU-, TPU- und NPU-Ressourcen besteht, braucht es jemanden, der das alles in robuste, wartbare und weltweit ausrollbare Systeme gießt. Mit den neuen Ironwood-Superpod-Aufträgen signalisiert Foxconn, dass man diesen Platz in der ersten Reihe beanspruchen will – und dass NVIDIAs Vormachtstellung erstmals auf breiter Front von maßgeschneidertem Big-Tech-Silizium herausgefordert wird.