Der NVIDIA DGX Spark wurde nie als „Gaming-PC“ angekündigt, sondern als winziger KI-Supercomputer für Labore, Unternehmen und Entwickler, die den ganzen Tag mit Modellen, Training und Inferenz arbeiten. Trotzdem ist klar, was passiert, sobald so ein Kasten mit kräftigem GPU-Block bei Enthusiasten landet: Jemand installiert Cyberpunk 2077 und schaut, was geht. Genau das ist jetzt passiert – und das Ergebnis sorgt für Staunen und Stirnrunzeln: Mit DLSS 4 und Multi-Frame Generation (MFG) schiebt der DGX Spark im Benchmark über 175 FPS bei aktiviertem Path Tracing.

Klingt nach „Mini-Supercomputer trifft High-End-Gaming“, wirft aber sofort die Frage auf, wie viel davon echte Leistung und wie viel davon AI-Magie ist.

Um das einzuordnen, muss man sich das Gerät erst einmal nüchtern anschauen. Der DGX Spark wird von verschiedenen OEMs angeboten, darunter auch direkt von NVIDIA. Die günstigsten Varianten liegen aktuell bei etwas über 3000 US-Dollar – ein spürbarer Rabatt gegenüber den ursprünglichen 4000, aber immer noch weit entfernt vom typischen Gaming-Rechner. Der Fokus liegt klar auf KI-Workloads: ein kompaktes System, das unauffällig im Rack oder auf dem Schreibtisch steht, Container mit Modellen startet, Daten verarbeitet und in der Regel nie einen Steam-Login sieht. Wenn also in Foren jemand spöttisch von einer „3K-Konsole“ spricht, liegt er nicht komplett daneben – es ist ein Profi-Tool, das nebenbei zeigt, was es in Spielen kann.

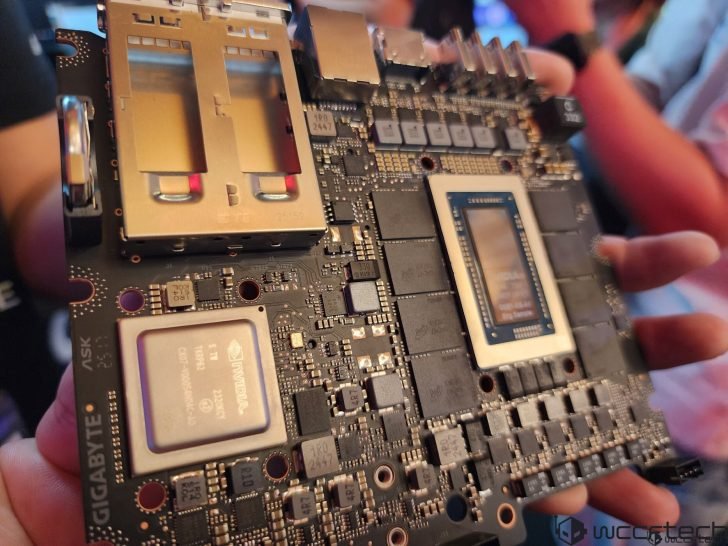

Herzstück des Systems ist der GB10-Superchip, der CPU- und GPU-Funktionalität auf einem Package vereint. Auf der CPU-Seite arbeitet ein 20-Kern-ARM-Design, ausgelegt auf Effizienz und Parallelität. Die GPU basiert auf der Blackwell-Architektur, bietet 6144 CUDA-Cores und greift auf denselben Speicherpool zu wie die CPU: 128 GB LPDDR5X mit rund 273 GB/s Bandbreite. Im Vergleich dazu bringt eine typische GeForce RTX 5070 12 GB GDDR-VRAM mit deutlich höherer Bandbreite, aber eben viel weniger Kapazität. Für KI-Modelle und speicherhungrige Spiele kann der große, wenn auch langsamere, gemeinsame Speicher ein echtes Plus sein. Das komplette SoC ist auf etwa 140 Watt TDP ausgelegt – inklusive CPU, GPU und Speicher.

Weil die rohe CUDA-Core-Anzahl identisch mit einer RTX 5070 ist, neigen viele dazu, den GB10 eins zu eins mit einer Desktop-GPU gleichzusetzen. Doch das greift zu kurz. Der Chip sitzt in einem viel engeren thermischen Korsett, teilt sich die Leistungsaufnahme mit der CPU und hängt an LPDDR statt an dedizierten GDDR-Modulen. Der Spark verhält sich deshalb eher wie ein extrem potentes APU-Design als wie eine klassische Grafikkarte. Wer die Cyberpunk-Zahlen ohne diesen Kontext liest, landet schnell bei falschen Erwartungen – und genau daraus speist sich ein Teil der hitzigen Diskussionen.

Die erste Hürde ist dabei nicht einmal die Performance, sondern der Weg, das Spiel überhaupt zum Laufen zu bringen. Auf dem DGX Spark läuft das hauseigene DGX OS, ein auf KI optimiertes Linux, das perfekt mit Containern, CUDA und PyTorch harmoniert, aber von Haus aus wenig Interesse an Games zeigt. Um Cyberpunk 2077 auf dieser ARM-Plattform zum Start zu bewegen, hat NVIDIA einen relativ zugänglichen Leitfaden veröffentlicht: Zunächst wird ein automatischer FEX-Installer für arm64 genutzt, der die Emulationsschicht einrichtet. Anschließend wird Steam über FEXBash gestartet, der Titel ganz normal geladen und in den Spieleigenschaften Proton 10.0-2 (Beta) als Kompatibilitätstool erzwungen. Innerhalb des Spiels lassen sich dann Raytracing, DLSS 4 und Multi-Frame Generation aktivieren. Wichtig ist dabei, Cyberpunk nach Änderungen an Frame Generation oder Raytracing neu zu starten, damit die Einstellungen wirklich greifen.

Vor diesem offiziellen Vorgehen sah das Bild deutlich weniger spektakulär aus. Frühe Nutzer, die Cyberpunk irgendwie unter Linux/ARM durchgeschoben hatten, meldeten etwa 50 FPS bei 1080p und mittleren Settings, meist ohne funktionierendes DLSS und ohne Raytracing. Das zeigte zwar, dass der DGX Spark technisch in der Lage ist, ein AAA-Monster wie Cyberpunk zu stemmen, aber von „Wow-Effekt“ konnte keine Rede sein. Mit der neuen, sauber aufgesetzten Pipeline kippt das Verhältnis: Der interne Benchmark meldet nun über 175 FPS bei hohen Details, aktivem Raytracing auf Ultra (vollständiges Path Tracing) und eingeschaltetem DLSS 4 MFG. Rein numerisch ist das ein dramatischer Sprung – von „okay spielbar“ zu „Marketing-Chart-Material“.

Genau an diesem Punkt schaltet sich die Community ein – und zwar mit voller Lautstärke. Niemand bestreitet, dass DLSS und MFG beeindruckende Technologien sind, aber sie verändern die Bedeutung der FPS-Zahl. Multi-Frame Generation fügt zwischen zwei real gerenderten Frames mehrere AI-generierte Zwischenbilder ein. Liegt die native Render-Rate zum Beispiel bei 45–50 FPS, kann der Zähler durch MFG problemlos auf 180–200 FPS hochschnellen, obwohl nur ein Viertel dieser Frames wirklich klassisch berechnet wird. Dank Reflex fühlen sich Steuerung und Bild trotzdem oft deutlich flüssiger an als „reine“ 50 FPS, doch viele Enthusiasten sehen darin keinen vollwertigen Ersatz für echtes, nativ berechnetes High-FPS-Gaming.

In den Kommentaren liest man deshalb Sätze wie „solide 1/4 echte Frames“, „zeigt uns die FPS ohne Frame Gen“ oder verkürzte Rechnungen à la „50 FPS ×4, Glückwunsch zur Zahlenkosmetik“. Es geht dabei nicht nur um Haarspalterei: Wer seine Hardware vergleicht, will wissen, wie viel Leistung tatsächlich renderseitig anliegt und was oben drauf an Bildverbesserung und Interpolation kommt. DGX Spark wird so zum Paradebeispiel dafür, wie schwierig es geworden ist, moderne GPUs nur anhand einer einzigen FPS-Zahl zu bewerten.

Spannend ist auch der Vergleich zur Konkurrenz von AMD. Dort steht mit Strix Halo ein potenter SoC in den Startlöchern, der ebenfalls kompakte Gaming- und Creator-Systeme befeuern soll. In ähnlichen Benchmarkszenarien mit 1080p, hohen Einstellungen und FSR 3 mit Frame Generation tauchen Schätzungen von rund 90 FPS für Cyberpunk auf – allerdings ohne Raytracing. Wird RT auf „Hoch“ gestellt und Frame Generation beibehalten, fallen die Werte laut Berichten auf etwa 40–50 FPS. Vor diesem Hintergrund wirken die Spark-Ergebnisse von über 175 FPS mit vollem Path Tracing – selbst unter massivem Einsatz von MFG – ausgesprochen konkurrenzfähig für ein integriertes 140-Watt-Design. Genau hier entsteht der Eindruck, dass NVIDIA nicht mehr nur Grafikkarten, sondern auch APU-artige KI-Chips aggressiv in Richtung Desktop schiebt – sehr zum Unmut eingefleischter AMD-Fans.

Ein weiteres Reizthema sind Temperatur und Lautstärke. In Foren kursieren bereits Memes nach dem Motto „einfach einen Tischventilator daneben stellen“ oder Bilder überhitzter GPUs mit Kommentaren wie „selbst NVIDIA gibt zu, dass das Ding ein Hitzkopf ist“. Dabei darf man nicht vergessen: 140 Watt sind im Vergleich zu High-End-GPUs erstaunlich moderat, und die ARM-Kerne des GB10 sind deutlich sparsamer als typische Desktop-CPUs. Trotzdem ist stundenlanges Path-Tracing-Gaming eine andere Art Dauerlast als Batch-Inferenz oder kurze Trainingsläufe. Entscheidend wird sein, ob der Spark seine Benchmark-Werte auch in echten Spielsitzungen halten kann – oder ob er nach einer Weile drosselt und die schöne 175-FPS-Geschichte sich eher auf kurze, sterile Testläufe beschränkt.

Zusätzlichen Zündstoff gibt die Art, wie über das System berichtet wird. Manche Leser sehen in Artikeln über den DGX Spark eine gut kaschierte Werbebotschaft und sprechen schnoddrig von „noch einem Ngreedia-Stück“. Andere trollen gleichermaßen Grün- wie Rot-Lager – mit Anspielungen darauf, dass egal ob Reflex 2 oder neue FSR-Varianten erscheinen, beide Seiten sich mit Akronym-Schlachten wie DOA und RDOA bewerfen werden. Dazwischen gibt es eine recht leise, aber sehr vernünftige Gruppe, die einfach nach Transparenz ruft: zeigt native FPS, zeigt FPS mit Upscaling, zeigt FPS mit Frame Gen – und lasst die Nutzer selbst entscheiden, welchen Wert sie welchem Szenario beimessen.

Der Blick in die Zukunft macht deutlich, dass DGX Spark nur der Anfang einer Entwicklung ist. Der GB10-Superchip zeigt, wie eng KI-Beschleunigung und „klassisches“ Gaming inzwischen zusammenrücken können, und die Softwareseite wird nicht stehen bleiben. FEX und Proton werden auf ARM besser werden, DLSS wird weiterentwickelt, MFG wird vermutlich zusätzliche Qualitätsmodi und Optionen erhalten. Es ist gut vorstellbar, dass kommende Generationen solcher Systeme einen klaren Schalter anbieten: etwa einen „Native-Only“-Modus für Puristen und einen „AI-Turbo“-Modus für alle, die maximale Gefühlt-Flüssigkeit wollen.

Unterm Strich bleibt der DGX Spark das, was er laut Datenblatt ist: ein kompakter KI-Rechner für professionelle Anwender. Aber die Episode mit Cyberpunk 2077 zeigt, dass diese Geräte längst begonnen haben, in das Hoheitsgebiet des Gaming vorzudringen. Ob man das nun als cleveres Marketing mit „aufgepumpten“ FPS-Werten oder als echten Vorgeschmack auf hybride Workstation-Gaming-Setups sieht, hängt stark von der eigenen Haltung zu Upscaling und Frame Generation ab. Klar ist nur: Die Zeiten, in denen ein FPS-Zähler schlicht die Anzahl gerenderter Bilder pro Sekunde angab, sind vorbei – und KI-Supercomputer wie der DGX Spark werden künftig nicht mehr brav in der Serverecke bleiben.

2 kommentare

Für eine 140-Watt-ARM-Kiste sind die Werte irre stark, als Workstation tagsüber und Gaming-Kiste abends könnte ich mir das schon gut vorstellen

Wenn NVIDIA mit solchen Superchips ernsthaft in den APU- und Desktop-SoC-Markt geht, bekommt AMD richtig Konkurrenz, Strix Halo ist noch nicht mal überall erhältlich