NVIDIA stellt die Speicherwelt leise, aber radikal auf den Kopf. Während klassische Serverplattformen bislang auf DDR-basierte Lösungen setzten, bereitet der Konzern seine nächste Generation von AI-Servern darauf vor, vor allem mit LPDDR zu laufen – also genau jener stromsparenden Speichertechnik, die man bisher aus Smartphones und ultradünnen Notebooks kennt. Aus Sicht der Ingenieure klingt das nach einer cleveren Optimierung.

Für PC- und Handy-Käufer könnte es sich jedoch als Beginn einer langen Phase knapper Verfügbarkeit und deutlich höherer RAM-Preise herausstellen.

Seit Monaten warnen DRAM-Hersteller vor einer neuen Knappheitsphase. Die Nachfrage nach Speicher wird von Generativer KI, riesigen Sprachmodellen und aggressiv ausgebauten Rechenzentren getrieben. Anfangs hoffte die Branche, dass der Effekt begrenzt bleibt, weil Kapazitätserweiterungen bereits geplant waren und neue Fabriken in der Pipeline stehen. Doch der AI-Boom beschleunigte sich schneller als die Fertigung. Parallel dazu wachsen die Bestellvolumen einzelner Großkunden wie NVIDIA, die sich langfristig Speicher-Kontingente sichern. In dieser Lage verändert ein Wechsel von DDR5 auf LPDDR in AI-Servern das Kräfteverhältnis innerhalb der gesamten Lieferkette.

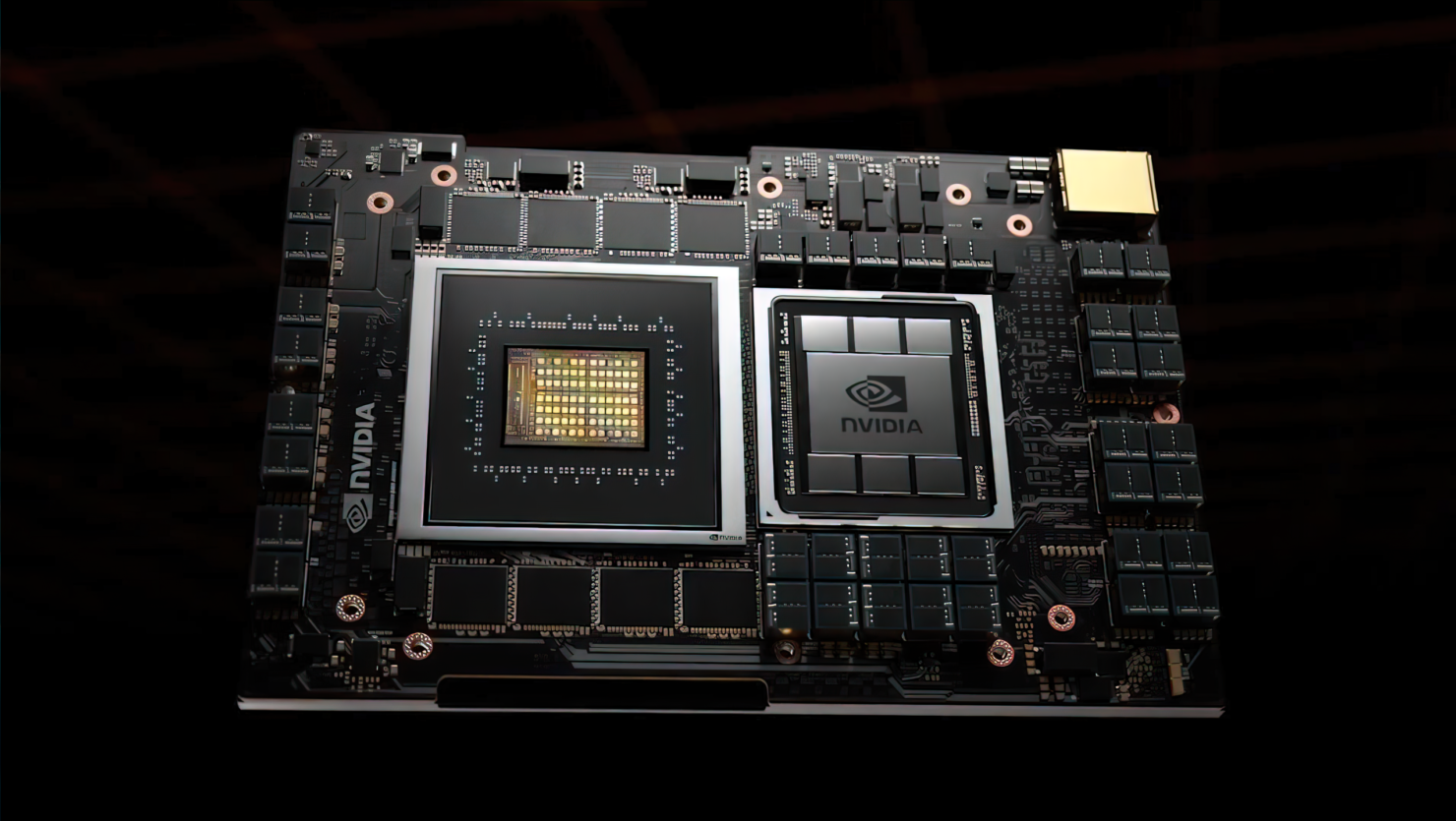

Analysten von Counterpoint sprechen von einem „seismischen“ Einschnitt – und das ist kaum übertrieben. Wer LPDDR bislang vor allem mit Smartphones verband, muss umdenken: Plötzlich verhält sich NVIDIA beim Einkauf wie ein großer Handy-Hersteller, nur dass ein einziger AI-Serverknoten mehr Speicher verschlingt als eine ganze Produktlinie von Telefonen. Die Produktionslinien, die einst sauber in „mobil“ und „PC/Server“ getrennt waren, werden durcheinandergewirbelt. LPDDR wird vom Spezialisten für mobile Geräte zum strategischen Rohstoff in der AI-Infrastruktur.

Die Preisprognosen zeichnen entsprechend ein angespanntes Bild. In Branchenkreisen ist von weiteren Anstiegen um bis zu 50 Prozent innerhalb weniger Quartale die Rede – zusätzlich zu bereits kräftigen Zuwächsen im Jahresvergleich. Übersetzt in Alltagssprache: Innerhalb relativ kurzer Zeit besteht das Risiko, dass sich die effektiven Kosten für DRAM grob verdoppeln. Die halb ironischen Kommentare, ein 32-GB-DDR5-Kit könnte bald so viel wie eine solide Mittelklasse-Grafikkarte kosten, wirken plötzlich weniger wie Memes und mehr wie durchaus denkbare Realität. Kein Wunder, dass sich manche Enthusiasten schon jetzt glücklich schätzen, mehrere DDR5-Kits „auf Vorrat“ im Schrank zu haben.

Für NVIDIA selbst ist der Schritt allerdings logisch. LPDDR punktet mit deutlich höherer Energieeffizienz pro Bit, arbeitet mit niedrigeren Spannungen und lässt sich mit ausgefeilten Fehlerkorrektur-Mechanismen kombinieren – essentiell, wenn gigantische Modelle über Tausende von GPUs hinweg trainiert werden. In Hyperscale-Rechenzentren zählt buchstäblich jeder Watt. Wird der Speicherverbrauch gesenkt, sinken Strom- und Kühlkosten über die gesamte Laufzeit des Clusters – und das summiert sich schnell zu Millionenbeträgen. Aus dieser Perspektive wäre es fast fahrlässig, nicht auf das effizientere Speicherformat zu setzen, auch wenn das für andere Kundengruppen Nachteile bringt.

Genau hier beginnt das Problem für Endkunden. LPDDR5 und seine Nachfolger stecken längst in den meisten Flaggschiff-Smartphones, in Gaming-Handhelds und besonders schlanken Notebooks, während DDR5 sich zum Standard in aktuellen Desktop-Plattformen entwickelt. Beide Welten – mobil und klassisch – konkurrieren um dieselben Fertigungsressourcen, die auch HBM für High-End-GPUs, GDDR für Gaming-Grafikkarten und RDIMMs für Server ausliefern. Wenn ein einzelner Großabnehmer große Teile der Wafer-Kapazität aufkauft, landet die gesamte Palette von HBM über DDR bis LPDDR im engen Nadelöhr. Ergebnis: Engpässe über viele Quartale und konstant hoher Preisdruck, selbst wenn die Nachfrage auf der Consumer-Seite zwischenzeitlich nachlässt.

Wie sich die Lage langfristig entwickelt, ist umstritten. Optimistischere Stimmen argumentieren, dass der starke LPDDR-Fokus von AI-Servern den Druck auf klassische DDR5-Module sogar etwas mindern könnte, weil ein Teil der Nachfrage verschoben wird. Pessimisten halten dagegen, dass NVIDIA letztlich alles kauft, was sich rechnet – zuerst LPDDR, aber notfalls eben auch jede verfügbare DDR5- und GDDR-Charge. In Foren liest man daher gleichermaßen zynische Kommentare à la „Ich bleibe einfach bei DDR4 und schaue mir das Spektakel aus sicherer Entfernung an“ wie auch ungelenke Forderungen nach politischem Eingreifen, falls ein einzelnes Unternehmen zu viel Einfluss auf globale RAM-Preise erlangt.

Dazu kommt, dass der Speicherzyklus notorisch launisch ist. Branchenkenner erinnern daran, dass die Halbleiterindustrie seit Jahrzehnten zwischen Überangebot und Knappheit pendelt. Einige Beobachter sehen in der aktuellen Situation zumindest teilweise eine künstlich verstärkte Verengung, die sich mit dem Hochlaufen neuer Fabs und effizienteren Fertigungsprozessen spätestens Richtung 2026 entspannen könnte. Trotzdem bleibt der Kernpunkt unverändert: Stand heute benötigt die AI-Industrie mehr fortschrittlichen Speicher, als die Fertigungskapazitäten kurzfristig liefern können.

Für PC-Bauer, Gamer und ganz normale Nutzer stellt sich daher die sehr praktische Frage: Jetzt aufrüsten oder abwarten? Wer ohnehin in den kommenden Monaten auf eine neue Plattform wechseln will, fährt womöglich besser, RAM nicht zu lange aufzuschieben, bevor die nächste Welle höherer Großhandelspreise vollständig im Retail angekommen ist. Das erklärt auch die teils spöttischen, teils ernst gemeinten Sprüche in den Kommentarspalten – von „Kauf jetzt, sonst wird’s bitter“ bis hin zu „Hättest du halt nicht gewartet“. Wer dagegen bereits 32 GB oder mehr installiert hat und keine Rekorde in Benchmarks jagt, kann den Sturm wahrscheinlich aussitzen und gelassen auf die nächste Preissenkung warten.

Unterm Strich ist der NVIDIA-Schwenk hin zu LPDDR in AI-Servern weit mehr als eine Randnotiz im Datenblatt. Er wirkt wie ein Katalysator, der strukturelle Schwächen in der Speicherindustrie brutal freilegt: zu wenig Reservekapazität, komplexe Abhängigkeiten und enorme Machtkonzentration bei wenigen Großabnehmern. Knappheit zwingt die Branche zu Innovation – zu neuen DRAM-Generationen, höherer Packdichte, besseren Energiesparmechanismen. Bis diese Fortschritte aber im Massenmarkt ankommen, bleibt RAM das unscheinbare, aber entscheidende Nadelöhr, das sowohl die Geschwindigkeit des AI-Fortschritts als auch das Tempo unserer ganz normalen PC- und Smartphone-Upgrades bestimmt.