Vor nicht allzu langer Zeit galt Samsung im Markt für High Bandwidth Memory (HBM) eher als Mitläufer: SK hynix und Micron kassierten die lukrativsten Aufträge für KI-Beschleuniger, während die Koreaner vor allem mit gescheiterten Qualifikationen bei NVIDIA in den Schlagzeilen auftauchten. Inzwischen dreht sich die Stimmung. Branchenquellen berichten, dass Samsung kurz davorsteht, von NVIDIA grünes Licht für seine HBM4-Stacks zu bekommen – möglicherweise schon in diesem Monat.

Gelingt dieser Schritt, rückt der Konzern schlagartig zurück ins Zentrum der wertvollsten Schicht der KI-Hardware: des Speichers.

Die Vorgeschichte ist schmerzhaft. Als die Nachfrage nach HBM3 und HBM3E explodierte und KI-GPUs zur neuen Währung im Rechenzentrum wurden, patzte Samsung genau dort, wo man es sich am wenigsten leisten kann. Frühe HBM-Module kämpften mit Zuverlässigkeitsproblemen bei der DRAM sowie massiven thermischen Herausforderungen: Viele Stapel, hohe Frequenzen, enge Gehäuse – die Kombination machte das Feintuning extrem anspruchsvoll. NVIDIA und große Cloud-Anbieter setzen bei HBM auf Qualifikationsprozesse, die eher an Luft- und Raumfahrt erinnern als an klassische PC-Komponenten. In diesem Umfeld verlor Samsung Design-Wins an SK hynix und Micron und musste zusehen, wie andere das KI-Gold schürften.

Statt halbgare Zwischenlösungen zu liefern, zog Samsung die Reißleine und startete einen Neustart auf technischer Ebene. Die 1c-DRAM-Generation wurde für HBM4 im Kern neu entworfen und mit einem modernen 4-nm-Basischip kombiniert. Das Ziel: hohe Taktraten, bessere Effizienz, stabilere Temperaturen – und das mit Ausbeuten, die einen echten Volumenmarkt ermöglichen. Intern hat der Konzern den Status „production ready“ bereits vergeben. HBM4-Stacks gelten als serienreif, erste Chargen werden als Muster an Schlüsselkunden ausgeliefert, damit diese die Chips in eigenen Testumgebungen durchleuchten.

Damit beginnt die zweite Hälfte des Marathons – die externe Qualifizierung. In den Laboren von NVIDIA und anderen Partnern laufen nun Langzeittests: Verhält sich HBM4 stabil bei Grenzfrequenzen? Bleiben Temperaturen und Leistungsaufnahme im Rahmen? Spielt der Speicher sauber mit den neuen Speichercontrollern und Package-Designs zusammen? Marktbeobachter gehen davon aus, dass diese Phase bereits in den kommenden Wochen abgeschlossen sein könnte. Dann entscheidet sich, ob Samsung lediglich auf dem Papier aufgeschlossen hat oder tatsächlich mit SK hynix und Micron in einer Liga spielt.

Der entscheidende Faktor dabei heißt Yield, also die Ausbeute verwertbarer Chips. Anders als bei klassischer DRAM kann ein Fehler in einer einzigen Lage einen kompletten HBM-Stack unbrauchbar machen. Die Kosten pro Chip sind hoch, Toleranzen gering. Wenn die Kombination aus 1c-DRAM und 4-nm-Basisdies die von Samsung avisierten Ausbeuten erreicht, hätte das Unternehmen einen der größten Stolpersteine der Vergangenheit aus dem Weg geräumt – und eine realistische Chance, in großen Stückzahlen in KI-Systemen zu landen.

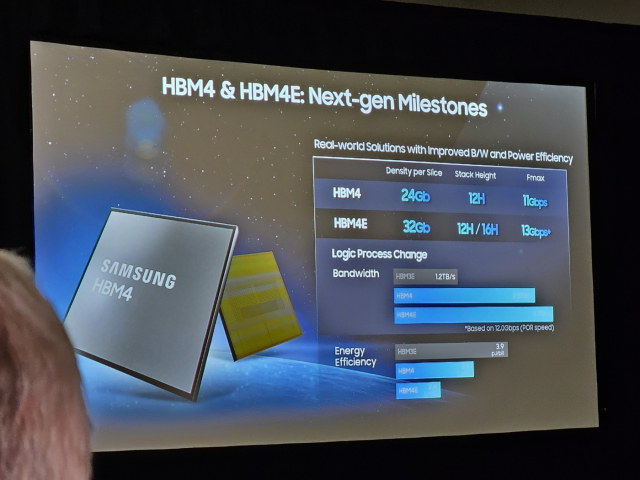

Auf dem Datenblatt liest sich HBM4 bereits wie eine Kampfansage. Samsung peilt Geschwindigkeiten von rund 11 Gbit pro Pin an. Je nach Konfiguration ergibt das in Summe etwa 2,8 TB/s Speicherbandbreite pro Stack – ein Wert, der klassische GDDR-Konfigurationen deutlich hinter sich lässt. Und die Roadmap endet dort nicht: HBM4E steht schon in den Präsentationen, mit angestrebten Raten jenseits von 13 Gbit pro Pin und Gesamtbandbreiten von über 3,2 TB/s pro Stapel. Um seine HBM4-Angebote noch attraktiver zu machen, setzt Samsung laut Brancheninsidern zusätzlich auf aggressive Preisgestaltung, um Käufer zu motivieren, Bestellungen stärker auf mehrere Anbieter zu verteilen.

Parallel dazu verschieben sich Fertigungskapazitäten. Ein spürbarer Teil der Linien, die ursprünglich für DDR5 und GDDR6 hochgezogen wurden, wird in Richtung HBM4 umgebaut. Das ist konsequent: Wer heute HBM produzieren kann, findet Abnehmer, bevor der Wafer überhaupt aus der Fabrik kommt. Für Samsungs Speicher-Sparte, die zuletzt unter niedrigen DRAM-Preisen und schwachen Margen litt, ist HBM4 damit mehr als nur Prestige – es ist eine mögliche Ertragsquelle, die den gesamten Speicherbereich stabilisieren kann.

Auf Seiten von NVIDIA ist das Interesse ebenso nachvollziehbar. Zu stark von einem einzelnen HBM-Lieferanten abzuhängen, ist gefährlich, wenn komplette GPU-Generationen und ganze KI-Roadmaps von dieser einen Komponente abhängen. Künftige Architekturen – häufig unter Codenamen wie Vera Rubin gehandelt – brauchen enorme und verlässliche Speicherbandbreite. Jensen Huang und sein Team wollen daher mindestens zwei, besser drei starke Partner, die HBM in großem Stil liefern können. Gelingt die vollständige Qualifizierung von Samsungs HBM4, verwandelt sich das bisherige De-facto-Duopol praktisch in ein Triumvirat.

Und Samsung entwickelt HBM4 ausdrücklich nicht exklusiv für NVIDIA. Auch AMD braucht konkurrenzfähige Speicheroptionen für eigene KI-Beschleuniger. Hinzu kommen die Hyperscaler – Google, Meta, Amazon – die seit Jahren an eigenen KI-ASICs und Spezialchips arbeiten. Für diese Designs ist HBM keine „Bonusoption“ mehr, sondern ein Pflichtbaustein, um mit der Konkurrenz mitzuhalten. Liefert Samsung hier verlässlich Stückzahlen, kann HBM4 rasch in unterschiedlichsten KI-Plattformen auftauchen, von GPUs über dedizierte Beschleuniger bis hin zu maßgeschneiderten Prozessoren für Rechenzentren.

Für PC-Spieler wirkt das alles dennoch ziemlich weit weg. Realistisch betrachtet wird HBM4 auf absehbare Zeit in Serverkarten und KI-Systemen bleiben, während Gaming-GPUs weiterhin auf GDDR-Speicher setzen. Die nächste Stufe ist hier GDDR7. Samsung hatte einst vollmundig Module mit bis zu 48 Gbit/s für Ende 2024 in Aussicht gestellt, doch die Realität ist komplexer. Inzwischen deutet vieles darauf hin, dass SK hynix die ersten GDDR7-Chips mit 48 Gbit/s öffentlich auf Konferenzen wie der ISSCC 2026 zeigen wird. Bis Gaming-Grafikkarten mit solchen Taktraten in den Handel kommen, dürfte eher Richtung 2027 vergehen.

Selbst bei moderaten Einstellungen zeigt sich, warum HBM eine eigene Liga ist. Läuft GDDR7 mit etwa 36 Gbit/s pro Pin, kommt man bei einem 256-Bit-Interface auf grob 1,1 TB/s Bandbreite. Eine 384-Bit-Anbindung bringt rund 1,7 TB/s, und ein extremes 512-Bit-Design kratzt an etwa 2,3 TB/s. Für Spiele ist das beeindruckend, aber ein einzelner HBM4-Stack mit rund 2,8 TB/s – oder ein zukünftiger HBM4E-Stack jenseits von 3 TB/s – legt die Latte wieder ein Stück höher. Kein Wunder, dass GPUs mit 512-Bit-Bus und maximal getuntem GDDR7 eher in der Liga der sündhaft teuren Flaggschiffe angesiedelt sein werden.

Gerade deshalb hat eine starke Samsung-Rückkehr im HBM-Markt einen größeren Effekt als nur auf die eigene Bilanz. Drei ernsthafte Anbieter an der HBM-Spitze erhöhen die Resilienz der gesamten KI-Lieferkette, reduzieren das Risiko von Engpässen und erhöhen den Druck auf alle Beteiligten, bei Effizienz und Performance draufzulegen. Auf lange Sicht können solche Impulse auch in den Mainstream durchsickern – etwa in Form effizienterer GDDR-Generationen, besserer Energiekennzahlen und zumindest etwas Preisdruck im oberen Leistungssegment.

Wenn NVIDIA den Haken hinter Samsungs HBM4 setzt und die Ausbeuten in der Massenproduktion halten, was interne Freigaben versprechen, wäre die Zeit des „Nachzüglers“ Samsung im HBM-Segment vorbei. Nach einem verpatzten Start in die ersten Wellen des KI-Booms hätte der Konzern sich zurück an die Front gearbeitet – als ein zentraler Pfeiler der Speicher-Infrastruktur, auf der die nächste Generation von KI-Modellen laufen wird.