Wenn man über künstliche Intelligenz und GPU-Leistung spricht, denkt man meist an Rechenkerne, Speicherbandbreite und Energieverbrauch. Doch das eigentliche Limit der neuen Generation von KI-Beschleunigern wie NVIDIAs Rubin und Blackwell liegt woanders: bei der Wärme. Hitze entscheidet, ob eine GPU wirklich ihr Potenzial entfaltet oder wegen thermischer Drosselung Leistung verschenkt.

Und genau hier setzt Phononic an – ein Unternehmen, das auf thermoelektrische Kühlung spezialisiert ist. Dessen Produktchef Larry Yang, ein Veteran mit über 30 Jahren Erfahrung bei Google, IBM, Microsoft und Cisco, erklärt, wie ihr System nicht nur Energie spart, sondern sogar die Amortisationszeit für KI-Infrastruktur auf wenige Monate verkürzen kann.

Vom Luftstrom zum Flüssigkreislauf – und jetzt zum Festkörper

„Kühlung begann einst mit Luft“, sagt Yang. „Ein einfacher Kühlkörper, etwas Aluminium oder Kupfer und ein Lüfter, der heiße Luft aus dem Server bläst.“ Doch die Zeit der Luftkühlung ist vorbei. Moderne Rechenzentren erzeugen eine Wärmedichte, die Luft schlicht nicht mehr bewältigen kann. Der nächste Schritt war die Flüssigkeit: Wasser oder Kühlmittel mit deutlich höherer Wärmekapazität. IBM nutzte solche Systeme bereits in den 80ern für Mainframes, und heute ist Flüssigkühlung Standard bei Hochleistungs-Servern.

Doch selbst diese Technologie stößt an Grenzen. „Mechanische Kühlung ist träge“, erklärt Yang. „Lüfter und Pumpen reagieren langsam, also überkühlen viele Betreiber ihre Rechenzentren vorsorglich.“ Das bedeutet verschwendete Energie und unnötige Kosten. Phononics Lösung? Festkörperkühlung – Systeme ohne bewegliche Teile, die in Millisekunden reagieren und nur dort kühlen, wo tatsächlich Hitze entsteht.

HBM – der unsichtbare Flaschenhals der KI-GPUs

Die meisten denken beim Thema Kühlung an den GPU-Chip selbst. Doch laut Yang liegt das wahre Problem bei der High Bandwidth Memory (HBM). Diese gestapelten Speicherchips sitzen direkt neben oder sogar über der GPU. Sie sorgen für enorme Datenraten, erzeugen aber auch konzentrierte Wärme. „Man stelle sich acht bis zwölf Speicherchips übereinander vor“, erklärt Yang. „Die unteren Schichten müssen ihre Wärme durch mehrere Schichten hindurch abgeben. Das ist wie eine Decke aus Isoliermaterial.“

Das Resultat: Der unterste Chip überhitzt, die GPU reduziert automatisch die Taktfrequenz – das berüchtigte Throttling. Dadurch laufen KI-Modelle langsamer, als es die Hardware eigentlich zuließe. „HBM ist mittlerweile die thermische Grenze der GPU“, so Yang. „Selbst modernste Flüssigkühlung erreicht diese Hotspots nicht effektiv.“

Phononics Ansatz: Präzise Kühlung durch Thermoelektrik

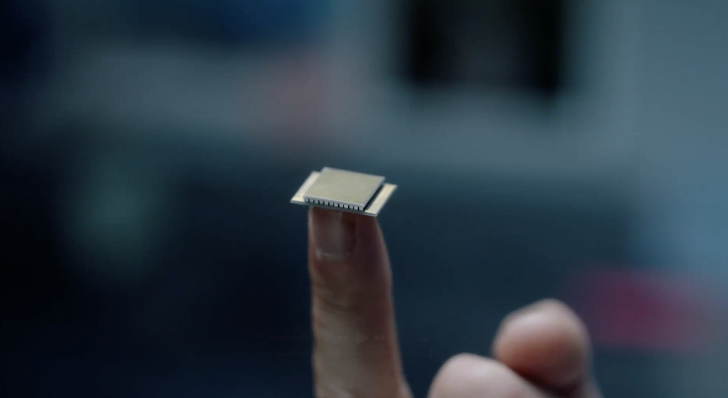

Phononic setzt auf den sogenannten Peltier-Effekt. Dabei transportieren spezielle Halbleitermaterialien Wärme, wenn Strom hindurchfließt. Der Effekt ist seit über 100 Jahren bekannt, aber erst jetzt wirtschaftlich nutzbar. Phononic produziert winzige Module, sogenannte TECs (Thermoelectric Coolers), die aus hunderten mikroskopischer Halbleiterelemente bestehen. Diese werden direkt zwischen HBM-Stack und Kühlplatte platziert – quasi eine zusätzliche aktive Schicht zwischen Flüssigkeit und Speicherchip.

Die Besonderheit: TECs arbeiten bedarfsgesteuert. Ihr Controller misst die Temperatur jedes einzelnen Chips und aktiviert die Kühlung nur, wenn sie tatsächlich nötig ist. Über APIs wie Redfish lässt sich das gesamte System sogar softwareseitig orchestrieren – ähnlich wie Rechenleistung oder Netzwerke. So entsteht ein „Thermal Fabric“ – ein softwaredefiniertes Kühlnetzwerk, das intelligent auf Lastwechsel reagiert.

Blackwell, Rubin und der schnelle ROI

Mit der Einführung von NVIDIAs Blackwell-Chips wurde deutlich, dass Flüssigkühlung Pflicht ist. Rubin treibt diese Entwicklung weiter. Doch laut Yang liegt das eigentliche Potenzial in der Kombination aus Flüssigkühlung und TEC-Schicht. „Unsere Module verhindern das Drosseln der HBM und holen so zusätzliche Leistung heraus“, erklärt er. „Das bedeutet: weniger GPUs für die gleiche Rechenlast.“

Weniger GPUs heißt weniger Stromverbrauch, weniger Netzteile, weniger Fläche und weniger Kühlkosten. „Die Investition in unsere TECs zahlt sich innerhalb von ein paar Monaten aus“, betont Yang. „Anstatt neue Hardware zu kaufen, steigert man die Effizienz der bestehenden.“ Für Betreiber von KI-Rechenzentren ist das Gold wert – besonders in Zeiten steigender Energiekosten und Lieferengpässe bei GPUs.

Mehr als GPUs – Kühlung auch für ASICs und Netzwerke

Die gleiche Idee gilt für andere Chips: maßgeschneiderte KI-ASICs, Netzwerkprozessoren oder optische Module. Überall, wo kleine, dichte Chips in engem Kontakt arbeiten, entstehen lokale Wärmespitzen. Phononics modulare TECs können auch hier punktgenau eingesetzt werden. „In Netzwerk-Switches mit Co-Packaged Optics sehen wir die gleichen Probleme“, sagt Yang. „Unsere Technologie funktioniert dort ebenso – sie senkt Temperaturspitzen und erhöht die Signalintegrität.“

Effizienz, Kosten, Nachhaltigkeit – drei Seiten derselben Medaille

Warum spielt Kühlung plötzlich eine so große Rolle? Weil sie Performance, Wirtschaftlichkeit und Umwelt gleichzeitig betrifft.

- Performance: Gekühlte Speicherchips laufen ohne Drosselung und ermöglichen höhere Taktraten.

- Kosten: Jeder eingesparte GPU spart nicht nur Anschaffungskosten, sondern auch Energie und Infrastruktur.

- Nachhaltigkeit: Feste Kühlmodule benötigen keine Pumpen oder Kältemittel – das reduziert CO₂-Ausstoß und Wartungsaufwand.

In einer Branche, die zunehmend auf ESG-Ziele achtet, ist das kein Nebenaspekt, sondern ein Wettbewerbsvorteil.

Wie sieht die Zukunft der Rechenzentrumskühlung aus?

Yang ist überzeugt: Das Thema steckt erst am Anfang. „Wir werden Kühlung bald als Software-Ressource betrachten – genauso wie Rechenleistung“, sagt er. Phononic arbeitet bereits an Prototypen, bei denen das TEC-Material direkt auf das Silizium des Chips aufgebracht wird, um die Wärme noch effizienter abzuführen. Auch Mikrokanäle im HBM-Stack, durch die Kühlflüssigkeit fließt, gelten als nächster großer Schritt.

Darüber hinaus rückt die Integration in die Infrastruktur näher: Wenn KI-Cluster orchestriert werden, könnten Kühlstrategien automatisch mitgeplant werden. Je nach Workload – Training, Inferenz, Langzeitbetrieb – entscheidet das System selbst, wie stark welche Zonen gekühlt werden. „Softwaredefinierte Thermodynamik“ klingt futuristisch, ist aber in greifbarer Nähe.

Schlussfolgerung: Kühlung als strategischer Faktor

Die KI-Revolution ist nicht nur ein Wettlauf um Rechenleistung, sondern um thermische Effizienz. Wer mehr Performance pro Watt und pro Quadratmeter erzielt, hat den Vorteil. Phononic zeigt, dass Innovation nicht immer in größeren Chips steckt, sondern in der präzisen Kontrolle von Temperatur. Die Kombination aus Flüssigkühlung und Thermoelektrik könnte zur neuen Standardarchitektur werden – effizient, flexibel und ökonomisch. Denn im Ende zählt nur eins: Leistung, die nicht im Hitzestau verpufft.

2 kommentare

Ich will das mal live in einem Hyperscaler sehen, nicht nur auf Folien

600 kW in einem Rack? Das ist kein Server, das ist ein Grill 😂